„Информацията е неопределеност, изненада, трудност и ентропия"

„Случайните съобщения носят повече информация"

Клод Шанън

„Една общност е в състояние да разшири влиянието си, ако разшири ефективността при трансмисия на информация“

Норбърт Винер

Информацията като термин и дума се е превърнала в част от понятийния апарат на обществото. Всички ние живеем в информационно общество и почти няма човек, който да не разбира общото значение на думата. От друга страна, информацията е комплексна величина и многозначен термин. Науката за информацията и информационната теория отделят особено внимание на дефинирането на терминологията, свързана с информацията и от тази гледна точка ще предложим няколко популярни дефиниции. Информацията е термин с латинска основа informatio и означава ‘предавам форма на нещо’.

През 1945 г. в една засекретена статия Клод Шанън употребява фразата „теория на информацията". Според него информацията е неопределеност, неочакваност, трудност и ентропия. Основни тези, свързани с понятието са следните: информацията се свързва с неопределеността; неопределеността може да бъде измерена, като се преброят количествата възможни съобщения; при условие, че е налице само едно съобщение, то тогава липсва неопределеност, но в случая няма и информация; някои съобщения могат да бъдат по-вероятни от други, като информацията предполага неочакваност, или още е способ да се изразяват вероятности.

При търсене на данни относно термина „информация“ в специализираната мрежа на „Волфрам алфа“ (вж. www.wolframalpha.com) се извличат следните резултати: информацията е получено и разбрано съобщение; знание, придобито с помощта на изследване, експеримент, или инструкция; колекция от факти, на базата на които можем да правим заключения; (комуникационна теория) измерване на неопределеността с помощта на числени методи. Понятието информация се появява на английски през 1387 г. и произхожда от латински и старофренски. Честота на употреба на термина значително нараства след 1950 г. Синоними на понятието са: инфо, данни, ентропия, селективна информация. Други термини, свързани с информацията, са: база данни, форматирани данни, детайли, факти, фактори, форматиране, ген. В по-широк смисъл понятията, които взаимодействат с термина са: съдържание, съобщение, мислене, знание, натрупване, асемблиране, колекция, информационна мярка, субстанция. Най-често използваните терминологични фрази са: конфиденциална информация, електронна информационна услуга, информационна епоха, информационен бюлетин, информационен процес, информационна система, информационна наука. При запитване и търсене на данни, относно понятието „информация“ в електронния вариант на енциклопедия „Британика“ се получават следните стойности: общ брой на резултатите – 4032; основни раздели и подтеми: информационен процес; информационна система; информационна теория; информационна наука; закони за достъп до информация; библиотека; наука за оптиката и други. Голяма част от показаното съдържание няма директна връзка с понятието. Само в частта за информационна наука се определя, че това е дисциплина която се занимава с процесите по съхранение и трансфер на информация. Взаимодейства с други дисциплини като наука за библиотеките, компютърна наука, лингвистика, както и с технологии за събиране, организиране, съхранение, извличане, интерпретация и използване на информация. Науката се развива активно след Втората световна война, като водещи учени са посочени Шанон, Уивър, Норбърт Винер. Първата програма за изучаване на тази наука е въведена през 1963 г. от „Института по технология" в Джорджия, САЩ. Информацията е мярка за неопределеност или за ентропия. Колкото е по-голяма неопределеността, толкова по-стойностна е информацията. Когато ситуацията е напълно предсказуема, в действителност липсва информация. Повечето хора обикновено правят асоциации между информация, знание и определеност, което противоречи на информационните теории. Съгласно схващанията на теоретиците по информация концепцията няма отношение към съобщението, фактите или значението. Информацията има отношение към квантифициране на стимулите или сигналите в дадена ситуация. Другото разбиране на тази теза е, че информацията – това са необходим брой съобщения, които могат да редуцират неопределеността на дадена ситуация. Някои съвременни автори казват, че съобщението се съотнася към значението; информацията – към селекция в определена система; а разбирането – към възможността за интегриране на селектирани данни в предварителното знание. Знанието, от своя страна, е подход за генериране на значение в определена физическа или социална система. Знанието включва още данни и отношение между елементите на данните.

Информационната теория е резултат не само от изследванията на Клод Шанън, но и на цяла плеяда учени преди него с различна ориентация и познания. Самият Шанън признава постиженията на учени като Хари Найкуист и Хартли. Едно от най-големите постижения на Шанън е концепцията, че всеки комуникационен канал има ограничения относно скоростта, измервана в бинарни единици за секунда. Въвежда и специална формула за измерване на количеството шум в информационната верига. Лошата новина, съгласно разработките на Шанън е, че математически е невъзможно да се създаде свободен от грешки комуникационен канал, без значение колко комплексна формула се използва за корекция на грешките и компресиране на данните. С други думи, не е възможно да се предаде информация по канал, без да се загуби част от нея. Математически Шанън доказва, че има начини да се кодира информацията така, че грешките да бъдат сведени до нула, въпреки наличния шум и нарушения при транслиране на сигнала. Това се постига с въвеждане на неограничено количество битове и код, така че ответната страна да може да възстанови по-голяма част от информацията. От друга страна, увеличаването на комплексността и дължината на съобщението може да забави максимално комуникационния поток, но същественото е, че сме в състояние да намалим до минимум грешките. Шанън още открива взаимоотношенията между информация, шум и енергия. Информационната теория се развива в три главни направления: широко вълнов технологичен спектър, кодиране на източника на информация и кодиране на комуникационния канал. Информацията се асоциира с неопределеността и може да бъде измервана, като се изчисли броят на възможните съобщения. Ако в определен случай е възможно генериране на само едно съобщение, то тогава липсва неопределеност и следователно няма информация. Шанън определя, че измерването на информацията е свързано с измерване на неопределеността или до каква степен „изборът“ е включен в селекцията на събитието или каква е неопределеността на изхода. Вероятността за поява на едно съобщение може да бъде една и съща или различна, но основният принцип тук е, че повечето „избори“ означават по-голяма неопределеност и повече информация. Парадоксалното в случая е, че случайните съобщения носят повече информация. Шанън свързва информацията с ентропията, докато Норбърт Винер говори за негативна ентропия. Винер смята, че информацията означава ред, но организираните неща не всякога съдържат повече информация. Винер предпочита термина безпорядък, вместо неопределеност. Шанън допълва, че по-голямата неопределеност в по-голяма конфигурация означава по-малко знание за ситуацията и следователно по-малко информация.

Шанън доказва, че в обикновения език излишните неща са над 50%, тоест съдържа звуци и букви, които не са строго необходими за предаване на съобщения. Надеждността на връзките в света, по съществен начин зависят от фактора „излишност“. Шанън допуска, че потокът от информация в обикновения език е повече от случаен; всеки нов бит частично е ограничен от предшестващия: по този начин всеки нов бит, в някаква степен, носи в себе си по-малко съдържание, от този, който съдържа реалната информация. Фундаменталният проблем на комуникацията, както посочват Шанън и други негови последователи, се заключва в това, как да се възпроизведе точно или приблизително съобщението в една точка, при условие че е селектирано и препратено от друга точка.

Водещи учени, развиващи теорията и разработващи проектите, са проф. Галагер, проф. Форни, Джеймс Маси, Питър Елиас, Ирвин Жакобс, Aндрю Витерби и Леонард Kлайнрок.

Информацията, според съвременните изследователи в областта на информационните науки, няма точна дефиниция и в различните области се определя по различен начин. В случая информацията се свързва с термините сигнали или съобщения, с вземането на решения, включва или изключва до известна степен когнитивни процеси. Може да се дефинира и като процес, който може да бъде изобразен с помощта на алгоритъм или вероятност. Информацията се разглежда едновременно като процес, ориентиран към знание, ограничаващо неопределеността; и като поредица от обекти/данни, документи, потенциални процеси/. Основни професионални услуги, свързани с информацията в съвременна организация са под формата на мениджмънт на знание и формиране на конкурентна интелигентност.

Според постановките, идеите и тезите на Пери Маршал (инженер по комуникационно инженерство и експерт по контролни и информационни системи, лектор и автор на поредица популярни книги) информацията не е материална величина, тя е повече от материя или енергия. Информацията е част от дизайна на системата. Дизайнът за разлика от образеца изисква информация. Организацията сама по себе си не представя информация. Информацията се състои от материя, енергия, намерение и воля. В сайта на университета Станфорд се дискутират функциите на информацията, акцент се поставя върху свойството ѝ да ограничава неопределеността. Това още означава, че когато сме абсолютно убедени в състоянието на определен процес, ние не можем да получим повече информация за него. Това предположение показва ясната връзка между информация и вероятност. По дефиниция неправдоподобните структури съдържат повече информация. Например, ако измерваме вероятността на процесите с реални числа разположени между 0 и 1, тогава при условие че P(A) = 1, тоест имаме абсолютна увереност, че нещо ще се случи, тогава I(A) = 0, тоест случването на събитието А не съдържа информация. В две последователни публикации, едната е на Шанън през 1948 г. и другата е в съавторство Шанън и Уивър (1949 г.) се достига до следния алгоритъм за ентропията на система, съставена от поредица съобщения „А“:

H(P)= −Σ(i∈A) pi log2 pi

В тази формула pi- е вероятността за поява на съобщенията в системата А. Използване на логаритъм от 2, дава гаранция че дължината на кода ще се измерва в битове, обобщаващ термин идващ от съчетанието „binary digits“. Веднага става ясно, че информационната ентропия на една система е максимална, когато вероятността за поява на всички съобщения е еднаква. Може да се измери и количеството информация I на индивидуално съобщение „x“ по израза I(x) = −log px. Колмогоров представя своята алгоритмична информационна теория през 1963 г., наречена още теория на комплексността, като се осигурява индуктивен метод за изчисляване на минималната дължина на съобщението. Резултати от теорията са следните: позволява да се формулират вероятностите и информационното съдържание за индивидуални обекти; полага основата на теорията за ученето, с помощта на компресиране на данни; предлага дефиниция на случайна поредица от символи.

Томас Ковър и Джой Томас разглеждат в детайли взаимодействието на информационната теория с други научни полета на изследване, като тук се включват: статистическа механика; теория на вероятностите, електрическо инженерство, комуникационна теория; компютърна наука / раздел „комплексни алгоритми“/. Информационната теория представя две екстремални, крайни точки във възможната мрежа от комуникационни схеми (компресиране на данни-минимум); (трансмисия на данни-максимум). Трансмисията на данни, определена като максимум I(X;Y) определя капацитета на канала. Комплексната величина „К“, която въвежда Колмогоров е приблизително равна на ентропията „H“ от теорията на Шанън, при условие че е изведена от случайността на процесите при разпределение на ентропията.

Базовите модели и теории, свързани с дефиниране на понятието информация са:

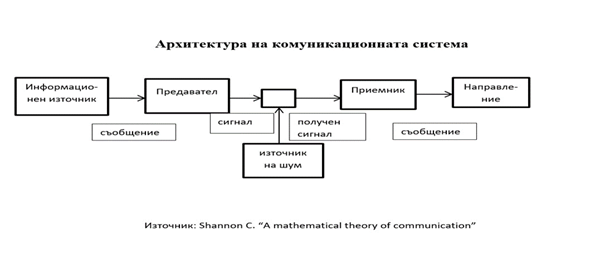

- теорията на Шанън: въвежда информационната верига източник-канал- направление на потока. Сигналите играят основна роля в процеса, но нямат отношение към съдържанието;

- когнитивен модел: изследва промените в когнитивната структура в зависимост от информацията, обработка на съдържание и постигане на ефекти;

- социален модел: изследванията се концентрират върху контекста, ситуацията, задачите при търсене на информация.

Други, развити във времето, информационни идеи и теории са следните:

- информационната теза на Фишер (1925), относно количеството информация и вероятност;

- модела за квантовата информация: „кюбит“ е обобщение на класическия бит и се описва като квантово състояние по двустепенната квантова-механична система – фон Нойман (1955) и Стоелтцнер (2001);

- информацията като „посредник“: формално и логично обяснение на идеите, свързани със знание и вяра (Хинтика (1973) и Бентъм&ван Руиж (2003);

- теория за семантичната информация: автори на модела са Бар-Хилел и Карнап (1953).

Норбърт Винер посочва, че една общност е в състояние да разшири влиянието си, ако разшири ефективността при трансмисия на информация. Възможно е да се направи измерване на този процес, като се извърши сравнение между броя на решенията, наложени отвън в една група, с тези, взети от самата група. По този начин можем да измерим автономията на групата. На практика групата може да притежава повече или по-малко информация от нейните членове. От друга страна, човешката организация може да владее повече информация при всички вероятни случаи, отколкото всеки един като част от цялото. Подобна позната тенденция е забелязана при библиотеките, когато могат да се превърнат в закрити пространства, благодарение на обема от книги. В тази насока на мислите д-р Ваневар Буш предлага да се използва помощта на машините, за да се търси информация в огромен масив от материали. Един от уроците, извлечен от тезите на Винер е, че всеки организъм се ориентира към дадена общност и е съпричастен към другите при условие, че владее средствата за придобиване, използване, съхраняване и трансмисия на информация.

Източници:

Shannon, C. E. A Mathematical Theory of Communication

Reprinted with corrections from The Bell System Technical Journal,

Vol. 27, pp. 379–423, 623–656, July, October, 1948.

Wiener, Norbert. Cybernetics or control and communication in the animal and the machine. Second edition. The MIT press.

Cambridge, Massachusetts.1965.

Cover Thomas. Joy A.Thomas. Elements of Information theory.

A Wiley-Interscience publication.1991. Printed in the USA.

Gleick, James. The Information. A history, a theory, a flood.

Pantheon books. NY, 2011.

Руси Маринов

За да коментирате, е нужно да влезете с потребителско име и парола.